文/VR陀螺 豌豆

北京时间6月8日凌晨1点,苹果WWDC 2021正式举办。由于疫情影响本次大会同去年一样将通过线上直播形式召开。苹果在WWDC大会公布了全新操作系统上线情况,包括:iOS 15、iPadOS 15、watchOS 8、macOS Monterey和tvOS。库克表示,即日起将推出开发者测试版,公测版定于7月更新,正式版于今年秋季更新。

库克与虚拟观众(图源:VR陀螺)

本次大会主要面向开发者,WWDC大会首日,主会场关于苹果AR产品的消息主要集中在软件及开发平台更新,值得关注的是以下几点:

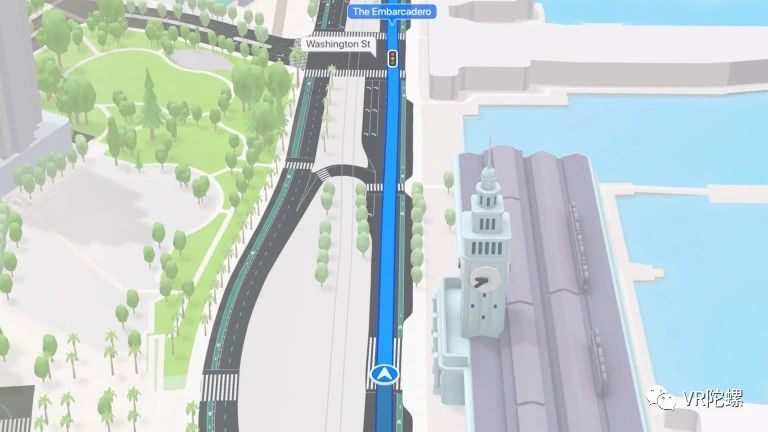

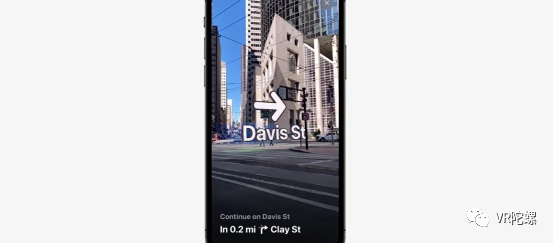

对标谷歌?苹果地图支持AR导航

在新系统iOS 15、iPadOS 15以及macOS Monterey的苹果设备上,开放类似谷歌地图AR实景导航的功能,在特定城市通过相机拍摄附近的景物,再利用数据库进行比对,提供3D式的步行导航功能。

部分城市可支持AR导航(图源:VR陀螺)

不同于传统的导航地图,新版苹果地图支持3D导航,可显示用户附近立体的街景及建筑,方便更好地标明复杂路段的地理环境。目前该功能仅支持伦敦、洛杉矶、纽约、费城、圣地亚哥、华盛顿几座城市。

新版地图将更新包括商业区、码头、建筑等新细节,例如海拔高度、新的道路颜色和标签设置。如果是司机使用苹果地图,将更直观地看到转弯车道、中间线、公交车道等等;行人使用苹果地图将会看到人行道和交叉路口的状况。

谷歌地图与新版苹果地图(图源:网络)

这些新功能的城市街道的细节变化与谷歌地图所做的更新相比更具有竞争性,苹果不仅将更新夜间3D景观光影变换,实时街景也在向谷歌靠近。苹果方面表示,未来还将更新显示人行道和自行车道。

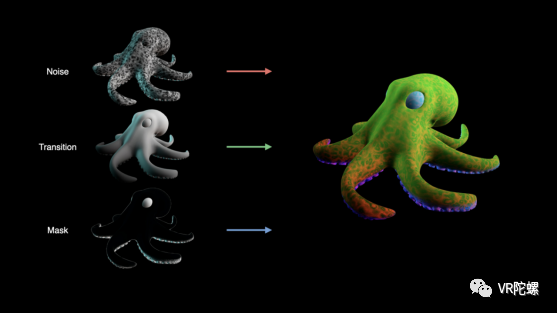

RealityKit 2框架更新

支持快速生成AR预览

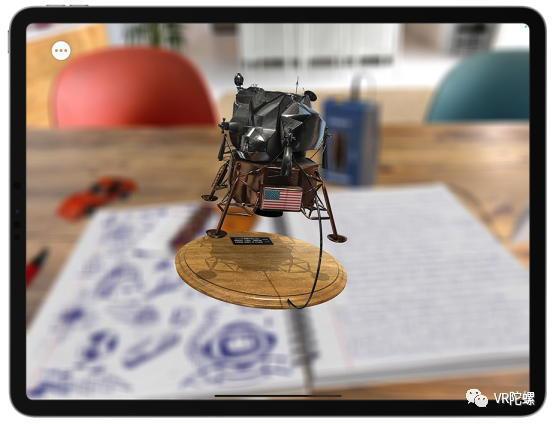

RealityKit是Apple为增强现实从头开始构建的渲染、动画、物理和音频框架,借助原生Swift API、ARKit集成、高清渲染等,使开发人员能够轻松地制作原型并制作高质量的 AR 体验。结合使用iPad Pro上的 LiDAR 扫描仪可利用视频纹理、场景理解、位置锚点、面部跟踪和改进的调试工具等功能进行AR开发。

图源:苹果

借助RealityKit 2中的高级渲染技术,开发人员还可以创造令人惊叹的视觉效果。学习编写自定义着色器,绘制实时动态网格,并探索后期处理效果,以帮助开发者设计AR场景。

对象捕捉(Object Capture)是RealityKit 2中的一项新开发工具,所有开发者都能利用苹果设备拍摄2D照片,在几分钟内创建3D对象;macOS Monterey可以将这些照片导入Cinema 4D,并生成AR预览,同时允许用户集成到Xcode或在AR Quick Look中查看。

图片

图源:VR陀螺

Object Capture支持使用USD创建3D工作流程,扫描真实世界对象的3D模型,利用第三方数字内容创建工具构建高质量的渲染序列。

RealityKit 2可通过自定义渲染目标和材质实现渲染操作,开发者可对AR对象及场景进行调整;允许开发者调用动态资源采集技术获取的图像,通过编程以逐帧调整图像,以定制更灵活的RealityKit体验;开发者可构建自己的实体组件系统,以便可以组织AR场景中的asset并将更复杂的功能构建到系统层中;除此之外,开发者可使用Swift API轻松创建玩家控制的角色,用户可以自由跳跃、缩放和探索创建的AR世界和基于RealityKit开发的游戏。

ARKit 5:锚点功能升级

新增“立即识别”功能

ARKit是新一代AR应用程序,苹果希望以改变人们与周围世界的联系方式。

用户可使用定位锚点将虚拟对象与现实世界的经度、纬度和高度连接起来。在iPad Pro上利用LiDAR扫描并获取深度场景显示。

图源:苹果

据悉,新版本的ARKit 5进行了更新,使用定位锚点,人们更容易感受到基于位置的AR体验。该功能使开发者能构建更好的AR体验,苹果表示开发者使用ARKit 5时可轻松发现和准确定位自己的虚拟内容。

定位锚点功能允许开发者的AR对象固定在设定的经纬度及高度,用户可围绕AR对象移动并进行观察。该功能目前支持iPhone XS,iPhone XS Max,iPhone XR,仅面向部分城市提供。

图源:苹果

ARKit 5还改进了动作追踪,并支持iPad Pro(第5代)超广角摄像头中的面部追踪。借助新的App Clip Code锚点,用户可以将App Clip或ARKit应用中的虚拟内容固定到打印或数字化的App Clip Code。

iOS 15:新增文本识别

有望嵌入AR眼镜

苹果相机现在可以识别照片中的文本(手写或打印)并使其可选择、可搜索、复制/粘贴等。它还可以识别文本以外的内容,包括动物品种、地标等。

文本识别(图源:VR陀螺)

初期将支持包括英文、简/繁中文、法文、意大利文、德文、西班牙文、葡萄牙文等七种语言。

文本识别可做到实时识别所拍摄到的文字内容,这项功能是基于采用机载处理的“深层神经网络”,并非云计算。虽然该功能目前无法与Google Lens相提并论,但仍是一个非常便捷的功能,适用几乎所有类型的图片,包括截图和网络图片。

Visual Look Up功能类似于识图软件,该功能可允许系统在照片中查找信息,例如识别花的品种或地标,或能为日后苹果AR眼镜提供技术支持。目前用户能在iPhone、iPad和Mac上体验该功能。

备受关注的隐私问题

正如预期的那样,苹果在主题演讲中加倍强调其十分重视隐私问题。

该公司推出了多种新的安全措施,其中包括一种称为“邮件隐私保护”的功能。苹果设备上的电子邮件应用程序现在将隐藏用户的IP地址和实际位置,邮件发送者将无法获取用户的个人信息。

图源:VR陀螺

iCloud+的订阅者可以利用额外的新隐私保护功能。包括Safari将提供隐私保护功能,它对用户设备的流量进行加密,第三方(包括苹果)无法拦截和读取用户正在搜索的内容。

Siri也在更新隐私保护功能。用户对Siri发出的指令将经过处理,防止对第三方应用获取用户音频。

转场中被丢出去的iPad(图源:VR陀螺)

以上为苹果WWDC 2021大会上的AR相关重点信息整理,VR陀螺将持续关注更新动态。你对本次大会的更新内容有什么看法?欢迎在留言区留下你的答案。

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息