编译/Frida.WS

一直有传言称,苹果的VR或AR头显将把眼球追踪功能引入其控制系统。对此,iPhone制造商提出了一个设计方案,使眼球追踪系统在运动状态下也尽可能保持精确。

鼠标和键盘一直是Mac及其他电脑的主要控制系统,而触摸屏是iPhone或iPad的主要使用方式。虽然近年来,尤其是在移动设备上,语音已经成为一种广泛应用的交互方式,但弊端是不够准确或灵活,不能适用于所有任务,比如在用户选择的特定显示点上执行操作。

在头戴显示器上,VR的控制系统主要是有运动跟踪功能的手持控制器。控制器可以根据头戴显示器的位置映射轨迹,在应用程序中用光标或手掌形状的标识定位。

眼球追踪是另一种与虚拟现实环境进行交互的方式,可以检测出用户显示屏上的特别关注。比起用手操作菜单或其他软件系统,这种交互方式更自然、更准确,也少了些尴尬。

然而,由于用户的耳机一直处于运动状态,眼球追踪的准确性会收到干扰。即使固定在头部,耳机仍然会移动,用户的眼睛和眼球跟踪系统之间的距离一直在变化,效率会降低。

周二,在美国专利商标局授予苹果的一项专利中,就提到了这款可以利用概率和场景检测来解决漂移问题的“注视点追踪系统的电子设备”。这并不是一个全新的硬件解决方案,而是有效地建议加入一个带有眼球跟踪系统的软件,以增强选择物品的能力。

专利文件概述了具体的工作原理:“电子设备中的控制电路可以为显示内容产生显著图。显著图可用于识别显示内容中的视觉兴趣项。显著图可以识别诸如可选按钮,文本和其他视觉兴趣项。诸如鼠标点击,语音命令和其他用户输入可以与注视点监测系统的输出结合,从而确定用户正在查看的对象。这允许控制电路精确地判断用户在实际屏幕中的注视点位置。”

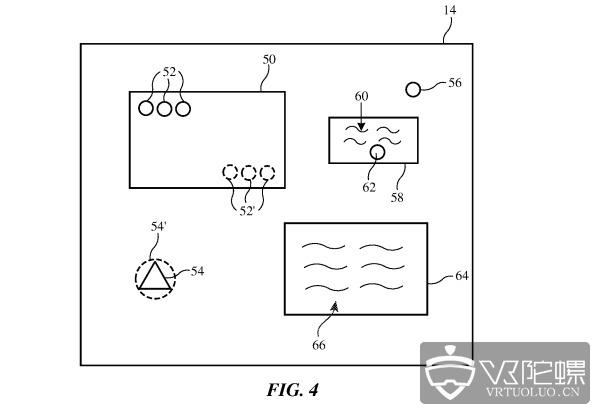

演示如何查看显著图上的特定显示点

在正常使用中,当用户进行选择时,注视点检测功能可以确定用户正在查看的对象,并使用显著图(Saliency Map),猜测他们具体在看什么,并使用一个单独的控制器来确认选择。

除了辅助选择,显著图还可以使眼睛跟踪系统更准确。通过比较用户的视线方位、视角、显著图上与注视点相关的兴趣区域,以及语音等其他数据,系统就可以确定头显的移动轨迹。

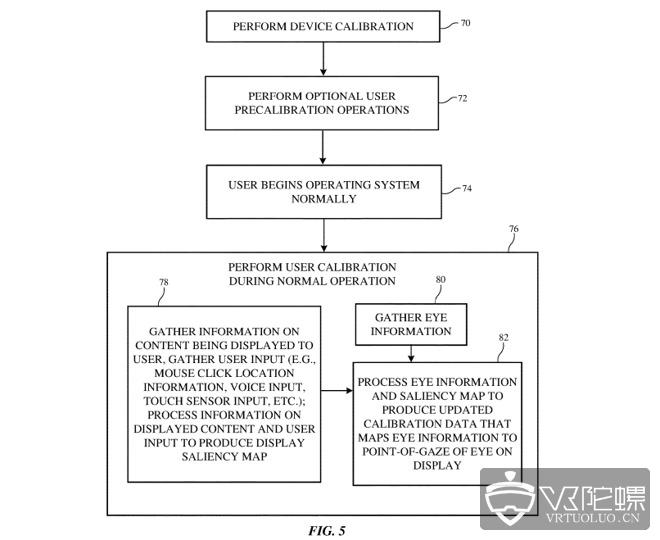

这种移动轨迹的检测可以实时校准眼球跟踪系统,增强准确性。

眼睛跟踪系统校准流程图

苹果每周都会向美国专利商标局递交大量专利申请,虽然不能保证这一设计理念会应用到未来的产品服务中,但它确实表明了苹果研发工作的兴趣领域。苹果已经研发AR和VR设备很多年了,有望在2020年发布AR智能眼镜。

苹果公司积累了大量相关技术专利,甚至尝试向AR和VR领域推广产品,比如在macOS上演示VR,以及在iOS上推出AR Kit。苹果还在2017年收购了德国一家专业眼球追踪技术的公司SensoMotoric Instruments。

2018年,苹果公司申请了一项眼球追踪系统的专利。系统利用“热镜”把红外光反射到用户的眼睛中,需要安装在离用户脸非常近的地方,尽可能带来舒适体验。2015年,苹果一项基于注视点的眼球追踪专利成功通过,用户可以通过注视屏幕控制iOS或macOS设备,同时也缓解了特罗克斯勒效应(Troxler Effect),减少对视觉互动体验的影响。

2019年5月的一份专利申请详细演示了怎样可以确定用户的主导眼球,这一数据点通过分析眼睛定位数据的多少,将进一步改善眼睛跟踪系统。

来源:Appleinsider

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息

.webp)