编译/VR陀螺

今天,美国专利商标局正式授予苹果公司一项与用户界面相关的专利,用于与未来的 HMD 交互,该界面将使用眼睛注视、触摸控制、手部及身体姿势以及Siri的组合。

更具体地说,苹果这项专利涵盖了使用眼睛注视与头戴式设备互动的技术。用户将能够使用他们的眼睛与HMD显示器上显示的用户界面对象进行互动。该技术提供了一个更自然和有效的界面,在一些示例性的实施方案中,允许用户主要使用眼睛注视和眼睛姿势(例如,眼睛运动、眨眼和注视)来操作设备。

HMD包括被配置为检测各种类型的用户输入的传感器,包括(但不限于)眼睛姿势、手和身体姿势,以及语音输入。在一些实施方案中,输入设备包括一个控制器,被配置为接收按钮输入(例如,上、下、左、右、输入等)。

图源:patentlyapple

图源:patentlyapple

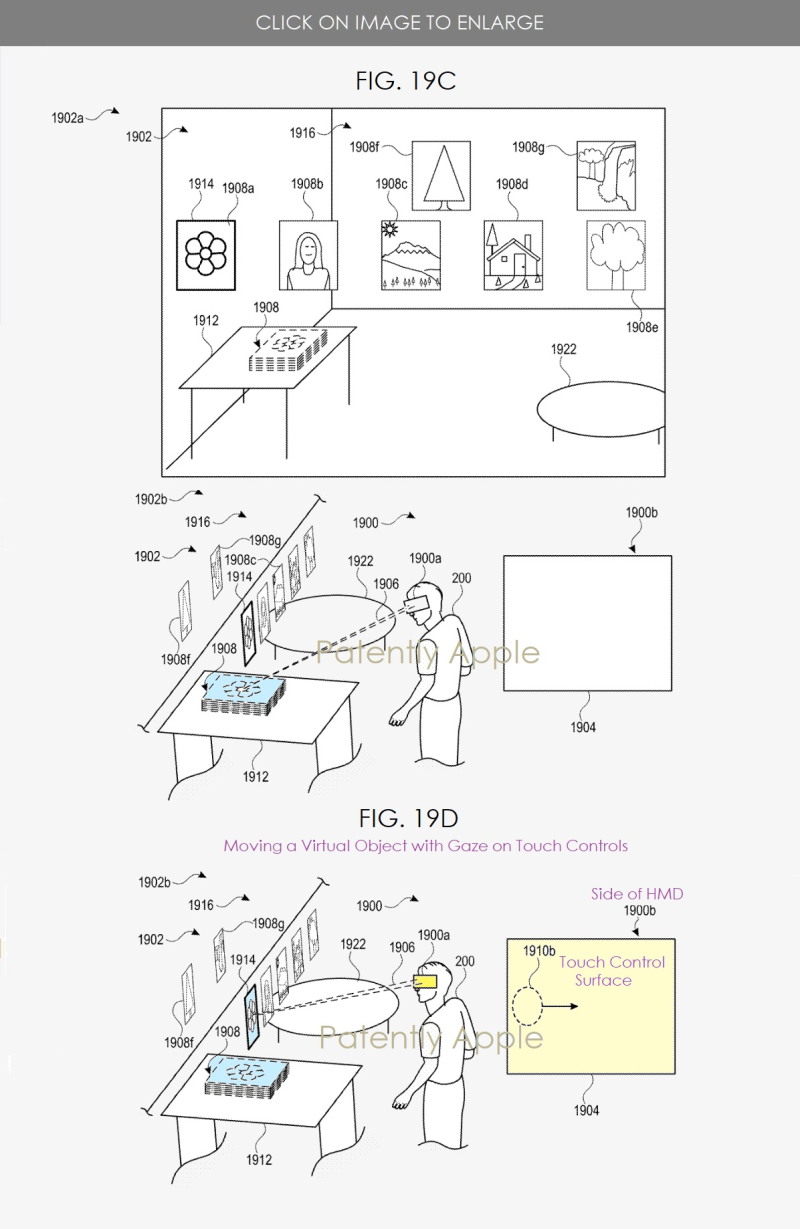

在苹果专利图19C中,我们看到,用户(#200)可以更容易地从堆栈(#1908)中选择特定的照片。在图19C中,#1908a-1908e的照片从桌子(#1912)上移开,直立呈现在用户视野中间。作为对接收用户输入(#1910a)的回应,最左边位置的照片(#1908a)被指定选中(例如,暂定选择)。

照片的指定由焦点指示器(#1914)表示,它包括一个围绕照片#1908a的粗体边框。在一些实施例中,焦点指示器包括一个指针、光标、点、球体、高亮、轮廓或幻影图像,可以直观地识别指定对象。在一些实施例中,HMD设备#1900取消了对照片#1908a的指定,并让照片#1908返回到桌子上,以响应接收进一步的输入指令(例如,选择退出按钮或解除触摸)。

在图19D中,用户输入#1910b包括一个从左到右的滑动或拖动手势。在一些实施例中,用户输入#1910b可以包括按下一个方向性按钮或一个口头命令("向右移动")。响应于接收用户输入#1910b,焦点指示器#1914根据用户输入#1910b的方向从照片#1908a移动到指定照片#1908b。

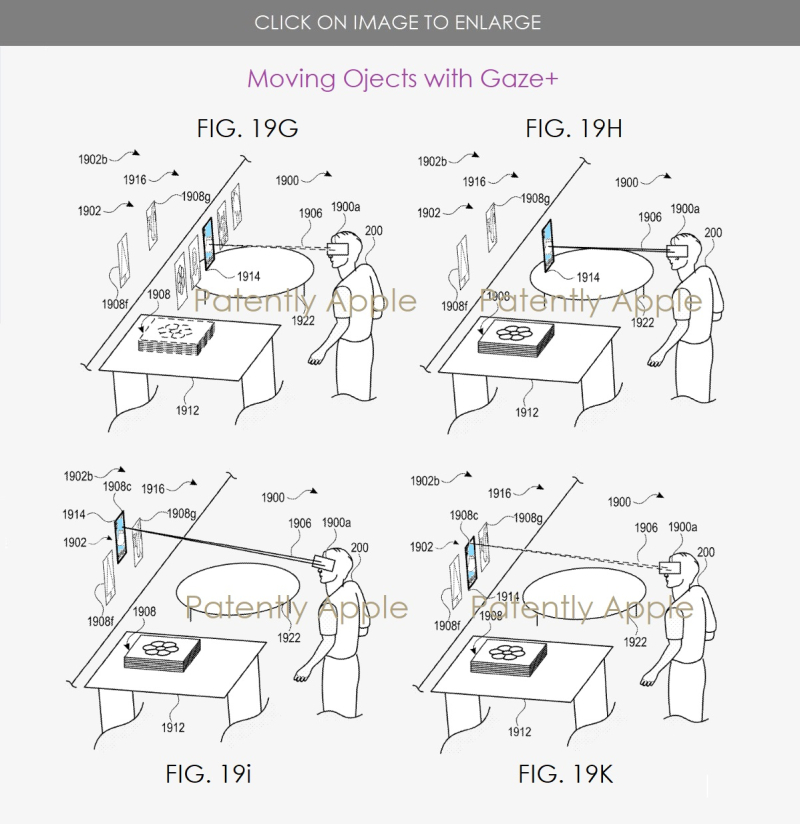

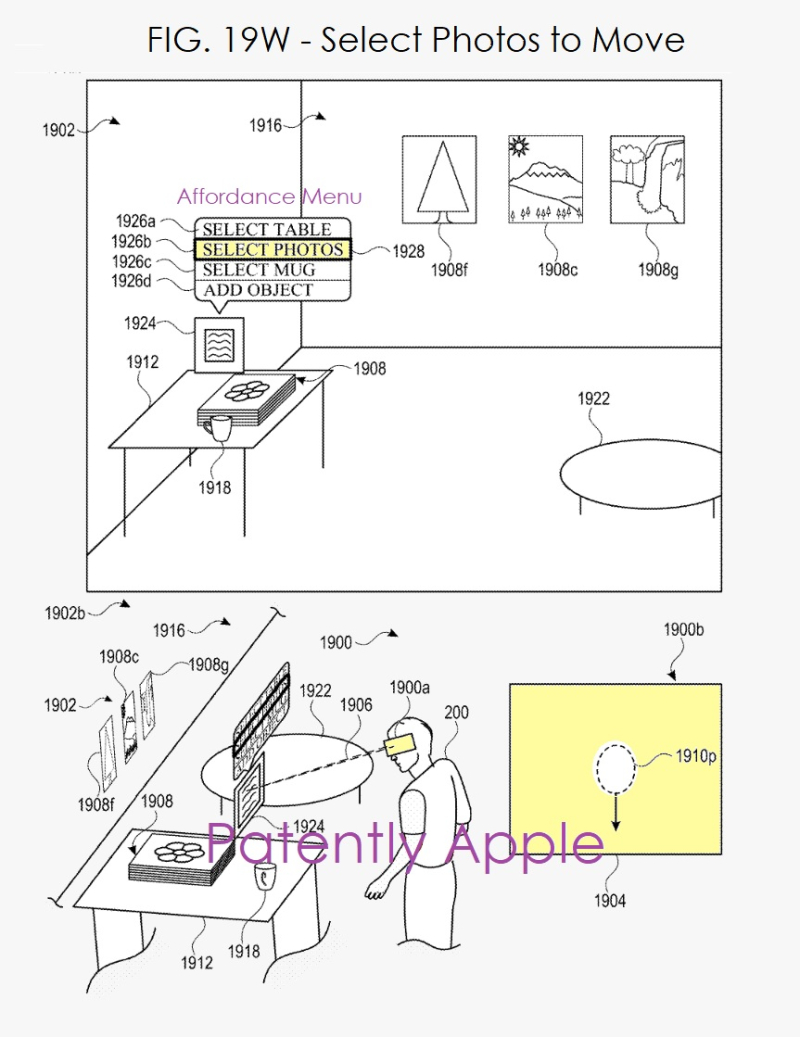

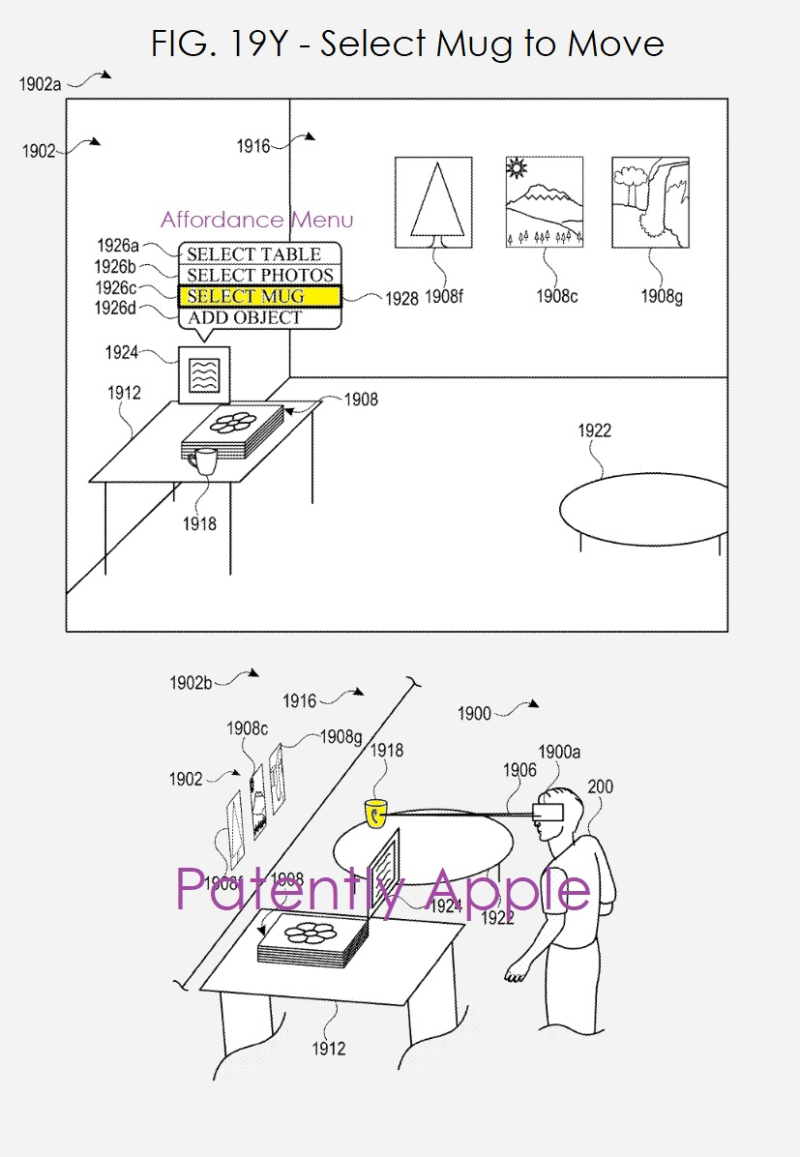

在下面的专利图中,苹果公司说明了如何使用注视点和触摸控制来移动虚拟环境中的物品,如绘画/照片,甚至咖啡杯物体。

图源:patentlyapple

苹果公司在专利中指出,HMD系统包括图像传感器,可选择包括一个或多个可见光图像传感器,如带电耦合器件(CCD)传感器,和/或互补金属氧化物半导体(CMOS)传感器,可用于从真实环境中获得物理物体的图像。

图像传感器还可选择包括一个或多个红外(IR)传感器,如被动红外传感器或主动红外传感器,用于检测来自真实环境的红外光。例如,主动红外传感器包括一个红外发射器,用于向真实环境发射红外光。图像传感器108还可选择包括一个或多个事件相机,其被配置为捕获真实环境中物理对象的运动。

图像传感器还可选择包括一个或多个深度传感器,被配置为检测物理对象与HMD系统的距离。在一些实施方案中,HMD结合使用CCD传感器、事件相机和深度传感器来检测HMD周围的物理环境。

虽然该专利主要集中在未来的混合现实(MR)头显上,但其所描述的技术也可应用于台式电脑、笔记本电脑、平板电脑和智能手机等设备上的传统用户界面。

想了解更多详细内容,请查阅苹果公司的授权专利11,132,162。

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息